论文链接:https://arxiv.org/pdf/2012.09164v2

代码链接:https://github.com/Pointcept/Pointcept ; https://github.com/isl-org/Open3D-ML

摘要

Point Transformer 是2021年ICCV提出的基于自注意力机制的3D点云处理模型,旨在解决传统点云处理方法(如基于投影或体素的方法)中几何信息丢失、计算效率低的问题。其核心创新在于将局部自注意力机制与位置编码结合,构建了一种高效的点云特征提取框架。

-

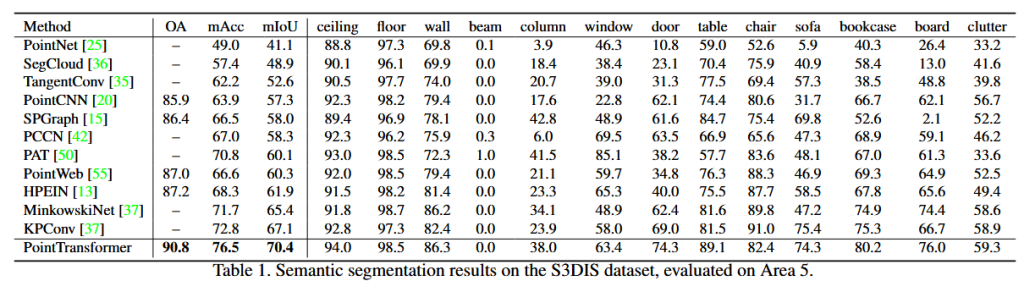

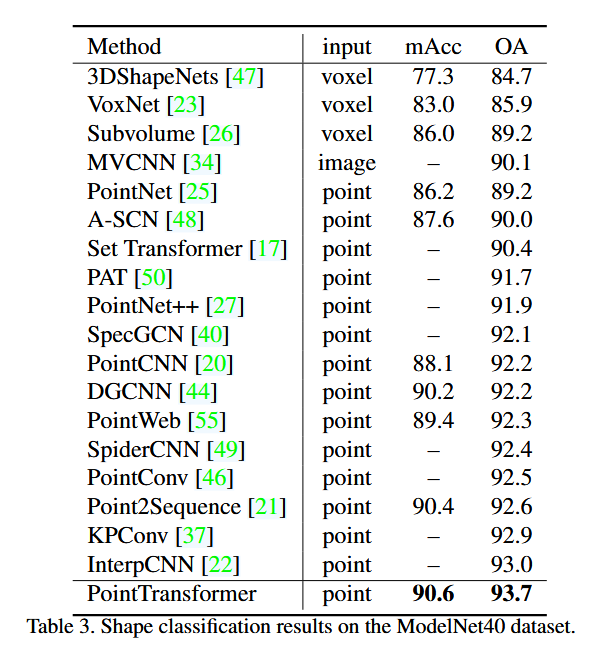

任务表现:在语义场景分割(如S3DIS数据集)中,Point Transformer以70.4%的mIoU刷新了当时的最优性能,首次突破70%阈值;

-

设计优势:通过局部邻域内的注意力计算(如KNN或ball query)降低计算复杂度,同时引入相对位置编码,增强模型对点云几何结构的捕捉能力;

-

通用性:支持分类、分割、场景解析等多任务,为后续点云Transformer模型(如Point Transformer V3)奠定基础。

主要贡献

-

局部自注意力机制

-

提出 Point Transformer Layer,通过局部邻域(如KNN或ball query)限制注意力计算范围,解决全局注意力计算量大的问题。每个点的注意力仅作用于其邻近点,显著提升效率;

-

采用 向量注意力(Vector Attention),通过特征差值\((\phi(x_i)-\psi(x_j))\)计算注意力权重,增强对点间关系的建模,优于传统标量点积注意力。

-

-

位置编码设计

-

引入 相对位置编码,通过MLP(θ函数)将点坐标差异\(p_i-p_j\)映射为位置偏移量\(\delta\),并与特征向量融合,提升对几何信息的敏感性;

-

在注意力权重和值的计算中均加入位置信息,避免传统方法仅依赖绝对坐标的局限性。

-

-

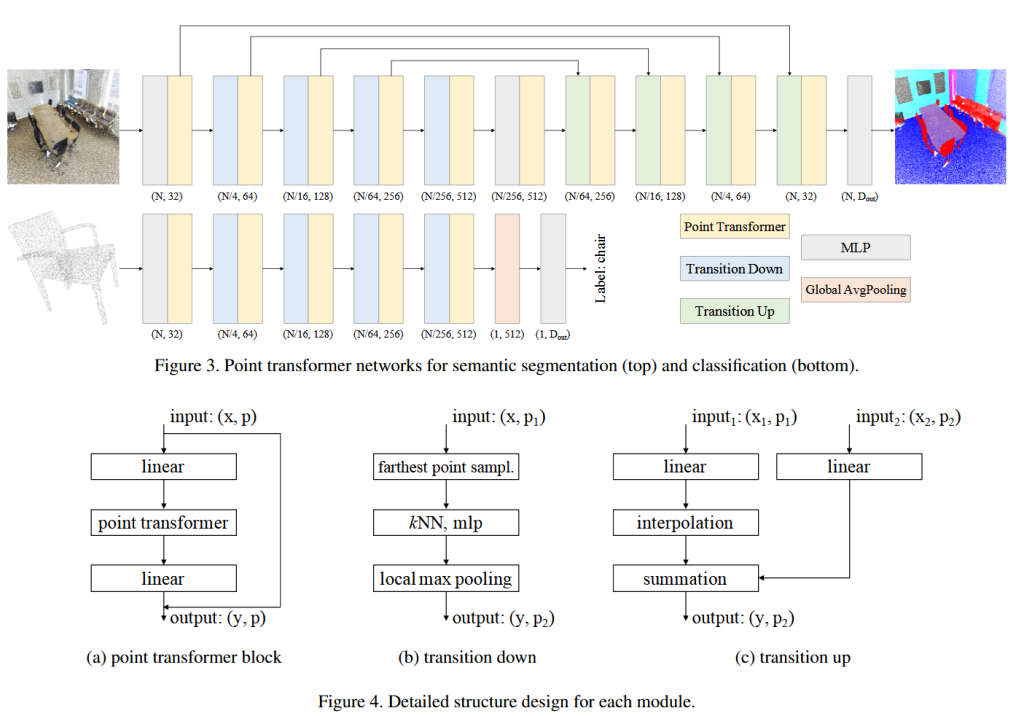

层级化U-Net架构

-

编码器-解码器结构:通过 Transition Down(降采样)和 Transition Up(上采样)模块实现多尺度特征融合,模拟CNN的多层感受野;

-

FPS采样与KNN分组:编码阶段使用最远点采样(FPS)选择关键点,解码阶段通过三线性插值恢复细节,结合跳跃连接保留局部信息。

-

-

高效性与通用性

-

在保持轻量化的同时(参数量显著低于传统3D卷积网络),支持大规模点云处理(如自动驾驶场景);

-

模型在室内场景(ScanNet)和物体部件分割(ShapeNet)任务中均表现优异,验证了其跨任务泛化能力。

-

网络结构

Point Transformer的网络架构基于U-Net,包含编码器(特征提取)和解码器(特征恢复)两部分,核心模块如下:

编码器(特征提取)

- Transition Down模块

- FPS采样:从输入点云中选取关键点(如从N点采样至N/4点),保证空间分布的均匀性;

- KNN分组:对每个关键点,查找其邻近的K个点(如K=16)作为局部邻域;

- 特征聚合:邻域特征经MLP、BatchNorm、ReLU后,通过最大池化生成关键点特征。

2. Point Transformer Block

- 局部自注意力:对每个点的邻域计算注意力权重,公式为:\(y_i=\sum_{x_j\in\mathcal{X}(i)}\rho\left(\gamma(\phi(x_i)-\psi(x_j)+\delta)\odot(\alpha(x_j)+\delta)\right.\),其中\(\delta=\theta(p_i-p_j)\)为位置编码。

- 残差连接:每个Block包含两个线性层和残差连接,增强训练稳定性。

解码器(特征恢复)

Transition Up模块

- 三线性插值:将低分辨率特征映射回高分辨率点云,结合编码器阶段的跳跃连接,融合多尺度信息;

- 特征拼接:插值后的特征与对应编码器特征拼接,通过MLP生成最终输出。

任务头

- 分类任务:全局最大池化后接MLP输出类别概率;

- 分割任务:解码器输出逐点特征,通过MLP预测语义标签。

实验结果

总结

-

高效局部注意力:通过邻域限制和向量注意力设计,显著降低计算复杂度(如S3DIS任务中推理速度达62 Hz);

-

几何感知能力强:相对位置编码与特征差值结合,提升对点云结构的建模能力;

-

多任务通用性:统一的U-Net架构适配分类、分割等多种任务,在室内场景中表现尤为突出。

没有回复内容